TRADUZIONE EDITORIALE E INTELLIGENZA ARTIFICIALE

di Giordano Vintaloro

1. Dodici anni di deliri

Sono solo dodici anni che Google Translate accompagna le nostre ricerche ma sembra sia sempre esistito. Prima del 2006, l’approccio prevalente alla traduzione automatica era la Rule-Based Machine Translation (RBMT), basata sul precaricamento di informazioni linguistiche su grammatica, sintassi e vocabolario delle lingue di origine e di destinazione.

Franz Och, il capo del gruppo di ricercatori che avevano lanciato Translate, ne illustrava così il funzionamento:

We feed the computer with billions of words of text, both monolingual text in the target language, and aligned text consisting of examples of human translations between the languages. We then apply statistical learning techniques to build a translation model (Och 2006).

Diamo in pasto al computer miliardi di parole di testo, sia il testo monolingue nella lingua di destinazione, sia il testo allineato costituito da esempi di traduzioni umane tra le lingue. Quindi applichiamo delle tecniche di apprendimento statistico per costruire un modello di traduzione (traduzione mia).

La Statistical Machine Translation (SMT) cui fa riferimento Och era appunto l’approccio concorrente a quello Rule-Based, in quegli anni scelto da Google, Microsoft, Facebook e altri, che prevedeva di generare testi tradotti utilizzando modelli statistici, ricavati a loro volta dall’analisi di corpora di testi bilingue paralleli.

L’idea, fondata, era che la potenza di calcolo combinata di migliaia di server potesse riuscire a produrre traduzioni migliori dell’approccio precedente. Och e i suoi collaboratori ritenevano che una volta raccolto un corpus di testi paralleli Phrase-Based (basati su piccole espressioni, non intere frasi) di circa 150-200 milioni di parole, e combinato con dei corpora di circa un miliardo di parole per ogni lingua e delle traduzioni affidabili prodotte da traduttori umani, si sarebbe ottenuta una base di dati sufficiente a fare lavorare bene il nuovo servizio basato su un motore di traduzione automatica statistica e con il tempo il sistema avrebbe imparato da sé, affinandosi sempre di più. Tutto questo in teoria, perché nella pratica sappiamo tutti com’è andata a finire:

Dan Evans. Guts.

That’s how he won this. The guts to approach the net time and again. Sometimes he got it wrong and was left exposed, but he kept coming anyway. The guts to persist with drop shots. The guts to unleash his elaborate backhand deep into Tomic’s territory no matter how many break points he was up against. The guts to pull a rain delay at deuce in the most tense game in the match (Guardian 2017)

Dan Evans. Budella.

È così che ha vinto questo. Il coraggio di avvicinarsi il tempo netto e di nuovo. A volte si ha sbagliato ed è stato lasciato a vista, ma lui continuava a venire comunque. Il coraggio di persistere con colpi goccia. Il coraggio di scatenare la sua elaborate rovescio in profondità nel territorio di Tomic: non importa quanti punti rottura era contro. Il coraggio di tirare un ritardo di pioggia al deuce nel gioco più tesa del match ( traduzione di Google Translate).

Nelle intenzioni dei suoi creatori, pur partendo da un livello iniziale di qualità più basso rispetto ai sistemi concorrenti, il Translate statistico sarebbe dovuto arrivare a risultati finali di gran lunga migliori. Quello che invece è successo è che l’espressione “tradotto con Translate” è diventata la metafora delle traduzioni fatte male, perché in dieci anni il risultato non si è discostato di molto dalla sua qualità iniziale. Detto in altre parole, un fallimento.

2. Nervi saldi

Secondo Kuhn (2009), le rivoluzioni scientifiche non avvengono mai per progressione graduale e costante ma perché a un certo punto si rende necessario e quasi inevitabile un totale cambio di paradigma. Nella primavera del 2016, dopo avere atteso invano dieci anni che il sistema producesse traduzioni comprensibili o quantomeno utilizzabili, la neonata divisione Google Brain, dedicata all’implementazione dei network neurali all’interno dei prodotti Google, ha proposto al gruppo di Translate di sostituire il motore traduttivo software (o engine, quello che oggi va di moda definire, con termine non proprio preciso, «algoritmo»). Sfruttando l’architettura dei Deep Neural Network (DNN) hanno dato così vita al nuovo motore Google Neural Machine Translation (GNMT) (Wu e altri 2016), un framework end-to-end capace di imparare – questo sì – da milioni di esempi di traduzioni affidabili disponibili online ed eseguite da traduttori umani, come ad esempio quelle disponibili sui siti dell’UE, dell’ONU, della NATO ecc.

Un framework è un’architettura o struttura logica di supporto alla programmazione che facilita lo sviluppo di un software, e spesso consiste in librerie di procedure già pronte da utilizzare. Il fatto che sia di tipo end-to-end specifica che il lavoro di codifica e decodifica delle informazioni in una rete avviene ai capi (ends) della trasmissione (ad esempio, solo sul server e sul pc locale) e non durante il percorso (in questo caso su internet). Un sistema di questo tipo permette di spostare il carico di lavoro e di dati dalla rete alle macchine.

Mike Schuster, Melvin Johnson e Nikhil Thorat, gli scienziati a capo del team, si sono subito proiettati anche oltre, progettando un’architettura che teoricamente andasse bene per qualsiasi coppia linguistica:

Our proposed architecture requires no change in the base GNMT system, but instead uses an additional «token» at the beginning of the input sentence to specify the required target language to translate to. In addition to improving translation quality, our method also enables “Zero-Shot Translation” — translation between language pairs never seen explicitly by the system (Schuster e altri 2016).

L’architettura che proponiamo non richiede modifiche nel sistema di base della GNMT, ma utilizza un token aggiuntivo all’inizio della frase di input per specificare la lingua di destinazione richiesta per la conversione. Oltre a migliorare la qualità della traduzione, il nostro metodo consente anche la «traduzione zero-shot» – traduzione tra coppie linguistiche mai viste esplicitamente dal sistema (traduzione mia).

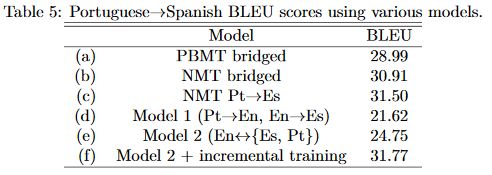

Google pone al cuore della nuova architettura un unico nuovo sistema valido per tutte le lingue (al contrario dei tanti sistemi precedenti, uno diverso per ogni coppia linguistica) che da grandi corpus impara non solo le traduzioni corrette a seconda del contesto, ma cerca di ricavare in maniera autonoma le regole grammaticali e sintattiche che poi andrà ad applicare anche a coppie linguistiche mai richieste in precedenza o delle quali esiste un campione statistico irrilevante (zero-shot). In un test comparativo di traduzioni zero-shot, gli scienziati hanno misurato una marcata superiorità dei modelli che si basano sulle reti neurali rispetto a quelli phrase-based (Johnson e altri 2016):

Immaginando la richiesta di una traduzione portoghese-spagnolo senza nessun dato di traduzione disponibile tra le due lingue, il modello 2 (f), che rappresenta un sistema neurale addestrato su un campione di quattro coppie linguistiche (inglese-spagnolo, spagnolo-inglese, inglese-portoghese e portoghese-inglese) con l’aggiunta di un addestramento incrementale su traduzioni affidabili tra le due lingue, registra una qualità maggiore di tutti i modelli precedenti (Phrase-Based (a), Neural Machine Translation addestrato con testi da tutte le lingue, con e senza passaggio per l’inglese (b, c) e neurale addestrato solo con testi provenienti dalle lingue richieste (d, e).

Il punteggio BLEU è un indice utilizzato per misurare la qualità nelle traduzioni automatiche (Papineni e altri 2002): si tratta di un indice matematico che dà risultati affidabili se applicato su grandi corpus come quelli impiegati da Translate; e, anche se non è l’unico indice esistente e non è esente da limitazioni, ci può dare un’idea dell’ordine di grandezza del miglioramento che il “nuovo” Translate ha introdotto nella seconda metà del 2016. Una differenza di 2 punti in questa scala rappresenta un considerevole salto in avanti.

La portata dirompente del salto di qualità è stata subito evidente e ha generato un’ondata di articoli un po’ romanzati sulla fine di un mondo e l’imminente inizio di una nuova era. Come il bel reportage di Gideon Lewis-Kraus per il «New York Times Magazine», dal titolo The Great A.I. Awakening (Lewis-Kraus 2016: Il grande risveglio dell’intelligenza artificiale), che per mesi ha seguito gli scienziati del team di Google Brain e ha ricostruito le vicende che all’inizio del 2016 hanno portato la divisione linguistica di Big G a adottare l’approccio neurale. O come l’intero numero del suo «Technology Quarterly» che l’«Economist» ha dedicato all’ascesa dell’intelligenza artificiale e delle reti neurali (Economist 2017). Ma che cosa sono, precisamente, questi due concetti che stanno rivoluzionando la tecnologia che ci circonda?

L’intelligenza artificiale è la branca dell’informatica che studia e progetta gli “agenti intelligenti”, macchine capaci di comprendere l’ambiente in cui si trovano e di interagirvi al fine di compiere determinate operazioni. I primi pionieristici – e fallimentari – esperimenti degli anni cinquanta e sessanta del secolo scorso, a causa dell’insufficiente livello tecnologico, hanno spento gli entusiasmi del pubblico e soprattutto degli investitori per molti anni, facendo stagnare la ricerca in questo campo. Oggi, diverse aziende come Amazon, Facebook, Apple, Baidu (il Google cinese) e Microsoft hanno ricominciato a investire grandi somme in quello che sembra il campo più promettente all’interno del grande business dell’intelligenza artificiale, ossia le reti neurali artificiali.

Gli Artificial Neural Networks (ANN) sono oggi il modello computazionale privilegiato – anche se non l’unico – per costruire materialmente le “macchine che imparano”. Ogni singolo nodo del sistema è concepito come un neurone umano molto semplificato, e quando un nodo-neurone viene attivato da una richiesta si collega agli altri tramite “sinapsi” e comincia un lavoro di gruppo che si sviluppa su molti livelli intermedi prima di arrivare all’altro capo del framework. La specificità di tali sistemi è che possono imparare a partire da un set relativamente ristretto di istruzioni di base, piuttosto che essere programmati integralmente dall’inizio per eseguire determinate azioni, da qui la similitudine con i neuroni umani. Nel nuovo Translate e in tutti i prodotti che utilizzano questo sistema la rete neurale non sostituisce i precedenti sistemi statistici, ma li integra laddove questi hanno difficoltà di applicazione, come ad esempio nelle richieste di traduzione per coppie linguistiche con pochi dati disponibili. A oggi Google e tutti i suoi concorrenti applicano l’architettura a reti neurali in tantissimi prodotti, dall’elaborazione delle lingue naturali al riconoscimento e al trattamento automatico di immagini, dall’assistenza vocale automatizzata alle auto senza guidatore, al supporto dati delle ultime generazioni di robot – ivi compresi i robot soldato.

Per questi prodotti Google, come Microsoft e altri concorrenti, rilascia anche delle API (Application Programming Interface), ossia delle librerie di programmazione che permettono ad altri programmi di dialogare direttamente con l’applicazione senza passare dall’interfaccia web. La API di Translate è sempre esistita, ma ora che il motore interno è migliorato anche l’uso della API rivela delle possibilità che prima sarebbero state decisamente scartate per un uso professionale. Alcune caratteristiche presenti nella versione web di Translate sono escluse dalla API, come ad esempio tutte le funzionalità collaborative («migliora traduzione»), ma in compenso è stata aperta la GT Community (https://translate.google.it/community) dove i traduttori possono registrarsi e partecipare al miglioramento della base di dati delle traduzioni affidabili controllando frasi ed espressioni.

Quasi tutti gli strumenti di CAT (Computer-Aided Translation) come SDL Trados (il più diffuso), MemoQ, OmegaT o l’ottimo e gratuito MateCAT, sviluppato da un pool di enti che comprende la nostrana Fondazione Bruno Kessler, possono collegarsi grazie alle API a server di traduzione automatica per aiutare il traduttore professionista nel suo lavoro. Prima, queste applicazioni venivano usate esclusivamente dai traduttori tecnici – i maggiori utilizzatori degli strumenti CAT – ma di solito servivano solo ad avere un riscontro aggiuntivo per le soluzioni ottenute con le memorie di traduzione proprietarie o legate al singolo programma, decisamente più affidabili perché verificate da umani. I traduttori editoriali, invece, oltre a non utilizzare in genere i CAT, trovavano assolutamente impraticabile usare i risultati di un traduttore automatico in una traduzione creativa com’è quella dei romanzi o dei saggi. Adesso, grazie a questa evoluzione, l’opzione di utilizzare questi strumenti merita di essere presa in considerazione.

3. Prove tecniche di traduzione

Gli strumenti di traduzione assistita danno il loro meglio se applicati a testi che privilegino la leggibilità e la mancanza di ambiguità. In questi ambiti, i traduttori che li usano riescono nel tempo a costruire delle memorie di traduzione affidabili e anche piuttosto ampie, dei veri e propri corpus linguistici settoriali utilissimi per controllare la correttezza e coerenza interna di un testo, fornendo risultati uguali nella lingua d’arrivo per espressioni uguali nella lingua di partenza.

Nella traduzione editoriale, invece, i testi tendono ad assomigliare a quelli che utilizziamo nella vita quotidiana e quindi sono pieni di ellissi, doppi sensi, ambiguità, deittici il cui riferimento non è per niente chiaro e univoco. Questo è il motivo per cui un traduttore editoriale di norma non trae nessun beneficio dall’utilizzo di un CAT. Ma ora che si apre la possibilità di un utilizzo professionale dei sistemi basati sui network neurali, mi è sembrato opportuno effettuare alcune prove su testi di vario genere lunghi circa 300-400 battute per avere un’idea di come sarà il futuro della categoria.

C’è ovviamente chi l’ha già fatto, anche se usando testi di prova più brevi (una frase o due), e su questo si possono consultare i diversi thread che sono stati lanciati su ProZ.com, il maggiore network-mercato di traduttori, non appena si è avuta la notizia del cambiamento di GT. Si possono vedere, ad esempio, la discussione http://bit.ly/2qhdUV0 oppure il blog di Antonio Toral (Toral 2018), linguista computazionale ora all’Università di Groningen che si occupa proprio di ricerca sull’uso di strumenti di traduzione automatica nella traduzione editoriale (Toral 2016). Io mi sono concentrato su alcuni tipi di testi che mi capitano spesso sotto mano e ne ho tratto alcuni dati abbastanza utili.

Charter in Delirio! Un esperimento con i versi di Emily Dickinson (Grillo 2016) è un libriccino uscito nel 2016, curato da Marzia Grillo e con postfazione di Martina Testa, in cui una piccola scelta di liriche della poetessa americana viene proposta in una traduzione automatica di un motore non specificato, che è lecito supporre sia, almeno nella maggior parte dei casi, Google Translate. Il titolo prende spunto dalla traduzione automatica di un verso della poesia 528, in cui Delirious Charter! veniva tradotto con «Charter in delirio!».

Il testo poetico è certamente la prova più difficile per un traduttore automatico che dovrebbe trarre la propria forza dall’apprendimento contestuale. Nella poesia la frammentarietà e la mancanza di contesto esplicito sfidano la ricostruzione del significato, che è quasi interamente affidata alla sensibilità del lettore, ed è per questo un ambito in cui la “macchina” ancora ha difficoltà. Ma, come previsto dagli autori, Translate si comporta come un bambino che apprende e non applica pedissequamente le sue conoscenze piazzando preposizioni a sproposito. Nella versione pubblicata nel 2016, ad esempio, mine è sempre «miniera», e by è sempre «di» o «da», mentre con l’arrivo del Translate neurale by viene spesso interpretato correttamente con «per» e mine viene giustamente reso con «mio». Delirious Charter! a volte viene lasciato in originale e a volte tradotto con «Carta delirante!». Il punto che lascia straniti è che confrontando questi tentativi con la traduzione di Silvio Raffo per il «Meridiano» Mondadori dedicato alla poetessa (Bulgheroni 1997), si nota come, pur nella sua bellezza, il testo della traduzione umana suona meno sincopato, meno disperato dell’originale che spezzava i versi con trattini lunghi (dash), e aggiunge un enjambement, che è una chiara scelta di leggibilità rispetto all’originale. Il traduttore automatico non coglie ancora pienamente il senso e quindi la possibile resa, ma sembra che non cada nella trappola della letterarietà e della leggibilità, caratteristiche tanto fumose quanto richieste dagli editori. Ecco la poesia con le sue traduzioni:

Mine – by the Right of the White Election!

Mine – by the Royal Seal!

Mine – by the Sign in the Scarlet prison

Bars – cannot conceal!Mine – here – In Vision – and In Veto!

Mine – by the Grave’s Repeal

Titled – confirmed –

Delirious Charter!

Mine – while Ages steal!

Traduzione Grillo 2016, XX:

Miniera – dal Diritto delle Bianche Elezioni!

Miniera – di Sigillo Reale!

Miniera – di Segno nella prigione Scarlatta

I Bar – non possono nascondere!Miniera – qui – in Visione – e in Veto!

Miniera – della Abrogazione della Tomba

Ha intitolato – ha confermato –

Charter in Delirio!

Miniera – mentre i Secoli rubare!

Traduzione di Google Translate, gennaio 2018:

Il mio – dalla destra delle elezioni bianche!

Il mio – dal sigillo reale!

Il mio – dal segno nella prigione di Scarlet

Bar – non può nascondere!Il mio – qui – In Vision – e In Veto!

Il mio – da Grave’s Repeal

Intitolato – confermato –

Carta delirante!

Mio – mentre le età rubano!</CM>

Traduzione Silvia Raffo (in Bulgheroni 1997, n. 528):

Mio per la legge della candida scelta!

Mio per sigillo reale!

Mio per il segno della rossa prigione

Che le sbarre non celano!Mio qui, nella visione e nel divieto!

Mio per l’abrogazione della tomba.

Confermato, intestato.

Delirante contratto!

Mio mentre sfuggono le epoche!/

Per passare all’altro capo dello spettro della difficoltà, ho fatto una prova con un romanzo sentimentale, un genere che non privilegia un vocabolario e una sintassi articolata ma che punta tutto sulle situazioni. Dal punto di vista linguistico, un ottimo candidato per un utilizzo estensivo del nuovo Translate. La mia cavia è stata l’incipit di Nicholas Sparks, Message in a Bottle (Sparks 2011; vedi Petrelli 2013), poi diventato anche un famoso film:

A cold December wind was blowing, and Theresa Osborne crossed her arms as she stared out over the water. Earlier, when she’d arrived, there had been a few people walking along the shore, but they’d taken note of the clouds and were long since gone. Now she found herself alone on the beach, and she took in her surroundings. The ocean, reflecting the color of the sky, looked like liquid iron, and waves rolled up steadily on the shore. Heavy clouds were descending slowly, and the fog was beginning to thicken, making the horizon invisible.

Ecco la traduzione di Google Translate:

Un vento freddo di dicembre stava soffiando e Theresa Osborne attraversò le braccia mentre fissava l’acqua. All’inizio, quando era arrivata, c’erano poche persone che camminavano lungo la riva, ma avevano preso nota delle nuvole e da molto tempo erano andate via. Ora si trovò da solo sulla spiaggia, e lei prese il suo ambiente. L’oceano, che rifletteva il colore del cielo, sembrava ferro liquido e le onde si arrotolavano costantemente sulla riva. Nubi pesanti scendevano lentamente e la nebbia cominciava ad addensarsi, rendendo l’orizzonte invisibile.

In questo caso sarebbero stati necessari soltanto dei piccoli interventi di post-editing per il solito accordo di genere e numero, oltre che per un paio di affinamenti di accezione («attraversò» per «incrociò», «prendere nota» per «notare», «prendere» per «osservare/accorgersi»). Per avere un termine di paragone, confrontiamolo con la traduzione italiana pubblicata di Alessandra Petrelli:

Soffiava un vento dicembrino, e Theresa Osborne incorociò le braccia mentre lasciava scorrere lo sguardo sull’acqua. Quando era arrivata sulla spiaggia c’era gente che passeggiava lungo la riva, ma le nubi l’avevano fatta allontanare già da un pezzo. Adesso era sola. Theresa si guardò intorno, L’oceano, che rifletteva il colore del cielo, pareva ferro liquido, le onde si frangevano regolari sulla battigia. Pesanti nubi scendevano lentamente e la nebbia cominciava a infittirsi nascondendo l’orizzonte (Petrelli 2013,5).

Tornando a tipi di testi “difficili”, stavolta in prosa, ho voluto provare a tradurre un pezzo di un romanzo sperimentale che mette alla prova non solo il traduttore, ma anche il lettore comune madrelingua. Ecco l’incipit di Ulysses di James Joyce:

Stately, plump Buck Mulligan came from the stairhead, bearing a bowl of lather on which a mirror and a razor lay crossed. A yellow dressinggown, ungirdled, was sustained gently behind him on the mild

morning air. He held the bowl aloft and intoned:

—Introibo ad altare Dei.

Halted, he peered down the dark winding stairs and called out coarsely:

—Come up, Kinch! Come up, you fearful jesuit!</CM>

Google Translate traduce così:

Buck Mulligan, entusiasmante, è venuto dalla scala, con una ciotola di schiuma su cui è stato attraversato uno specchio e un rasoio. Un abito giallo, senza sporgenza, era sostenuto dolcemente dietro di lui sulla lieve aria di mattina. Teneva la ciotola alzata e intonata:

-Introibo ad altare Dei.

Abbandonato, guardò le scale scure e scricchiolava:

– Sali, Kinch! Vieni, hai paura di jesuit!

Qui la difficoltà per il traduttore automatico si palesa nell’occorrenza (assai frequente anche nei discorsi reali) di uno schema di Winograd, ossia del problema della risoluzione di un’anafora da parte di un sistema di intelligenza artificiale che deve identificare il corretto antecedente di un pronome in una frase. In questo caso, la frase He held the bowl aloft and intoned contiene un’ambiguità per cui alof» e intoned potrebbero anche riferirsi entrambi a bowl, mentre in realtà un umano capirebbe quasi immediatamente che solo il primo aggettivo va riferito alla ciotola, mentre il secondo non è in questo caso un participio passato aggettivato bensì un simple past il cui soggetto è «he». Va notato anche che in questo brano Translate sembra disorientato e sopprime alcune parole (aggettivi, per lo più): questo potrebbe mettere in difficoltà nella fase di post-editing, per cui si potrebbe aggiungere un tempo di lavoro di ricerca e ripristino degli elementi mancanti.

4. Futurologia

Google Translate potrebbe essere già il passato. Il 9 maggio 2017 Facebook ha annunciato lo sviluppo di un suo sistema di Neural Network Translation (Gehring e altri 2017). Ma, a differenza di Google che utilizza un sistema di Recurrent Neural Networks (RNN), Facebook sta indagando le potenzialità dei Convolutional Neural Networks (CNN), i quali grazie a un’architettura che permette al sistema di imparare in maniera parallela anziché seriale, promettono di ridurre i tempi di addestramento della rete neurale di nove volte e incrementare nel contempo la qualità della traduzione (misurata in punteggio BLEU). Gli studiosi sostengono che ci vorrà ancora molto per arrivare a dei risultati tangibili, specialmente sul piano tecnologico. Ma il molto dell’informatica spesso diventa il poco, o il pochissimo, dei tempi umani.

La stessa Google, presentando il 5 ottobre 2017 i suoi nuovi smartphone Pixel2, ha introdotto quasi in sordina un accessorio a questi dedicato, gli auricolari Pixel Buds, che promettono di trasformare in realtà il sogno della traduzione simultanea (http://bit.ly/2mbkcAi), in questo caso ricordando un po’ il «pesce di Babele» della Guida galattica per gli autostoppisti (Adams 1996), un pesciolino che infilandosi dentro l’orecchio delle persone permetteva di comprendere e parlare tutte le lingue dell’universo. I Pixel Buds utilizzano il nuovo Google Translate, garantiscono “solo” 40 lingue (tutte terrestri) e hanno un piccolo ritardo nella traduzione, ma ad oggi sembrano la cosa più vicina a un traduttore automatico simultaneo.

Nel corso dell’ultimo anno, inoltre, la concorrenza europea del provider linguistico Linguee ha lanciato un traduttore automatico neurale altrettanto (a detta di qualcuno, anche più) efficiente di Translate: DeepL (https://www.deepl.com/translator). Specializzato in lingue europee, a oggi può tradurre molto accuratamente da italiano, inglese, tedesco, francese, spagnolo, olandese e polacco. Anche questo traduttore utilizza i Deep Neural Networks e impara continuamente, confidando su meno risorse di Google, ma specializzandosi in alcune lingue della nostra regione geografica.

Il futuro non è però soltanto privato: i prodotti open source stanno tenendo il passo anche grazie al supporto di importanti istituzioni. L’Università di Harvard, ad esempio, sostiene il progetto OpenNMT (http://opennmt.net/) che raccoglie contributi da programmatori e linguisti computazionali da tutto il mondo per creare un motore di traduzione automatica aperto e collaborativo, che già oggi dà risultati incoraggianti. Ed esiste, come già accennato, MateCAT (https://www.matecat.com/) nato con il supporto della Commissione Europea, della ricerca della fondazione Bruno Kessler, dell’Università di Edimburgo e dell’Università del Maine, in Francia, e il contributo dei corpora dell’italiana Translated.net, che offre già grandi possibilità per la traduzione creativa.

Rimangono tuttavia alcune domande. La prima è se, con tutte queste applicazioni pratiche in regime di aggiornamento permanente, serva ancora la teoria, disciplina “lenta” per eccellenza. E la risposta è sicuramente sì: senza i Translation Studies non sarebbe esistito un modello di processo traduttivo da implementare nelle reti neurali. Tuttavia, alcune teorie della traduzione che pongono molta enfasi sulla figura del traduttore e sulla necessità della sua visibilità, come quelle di Lawrence Venuti (Venuti 1999) o di Susan Bassnett (Bassnett 2013), saranno superate dall’utilizzo massiccio di strumenti di traduzione automatica e assistita. Molto probabilmente sopravviveranno le teorie che meglio riusciranno a conciliare la figura del traduttore umano con l’esplosione di mezzi che la tecnologia mette oggi a disposizione del professionista e che non possono essere ignorati dalla teoria.

Un’altra domanda è se esisteranno ancora i traduttori, o meglio, se ci sarà ancora bisogno dei traduttori umani. La crescita dell’accuratezza dei sistemi di traduzione automatica e assistita ne ha diffuso l’utilizzo e sta rendendo il traduttore in quanto autore sempre meno importante. La traduzione non sarà intesa più come un “artigianato artistico”, tranne che in pochi casi di traduttori-celebrità esperti in testi di nicchia o molto complessi (poesie o romanzi sperimentali, come abbiamo visto). Venuti ha sempre sostenuto che il traduttore, in quanto mediatore indispensabile, vada rivalutato e tolto dall’invisibilità in cui la cultura lo confina e ne esalta giustamente il ruolo avuto in passato per avere introdotto le letterature straniere in traduzione nelle letterature nazionali. È proprio grazie al lavoro dei traduttori del passato che oggi possiamo dire che Amleto (e non Hamlet) è un’opera di Shakespeare che fa parte a pieno titolo della cultura italiana. Ma il lavoro del futuro sarà per forza di cose diverso, e non sappiamo ancora in quale senso.

La terza domanda, discendente dalla seconda, è se il processo della traduzione editoriale cambierà, e quanto. In passato il traduttore si occupava dell’intero processo di traduzione, dal testo sorgente alla stampa, passando per la revisione, in cui dialogava e decideva eventuali cambiamenti perlopiù in accordo con il revisore. Oggi il professionista può lavorare in modo completo sul testo solo molto raramente, il dialogo col revisore è compresso o annullato dalle scadenze di produzione, e se s’imporrà l’uso massiccio della traduzione automatica come primo stadio della traduzione – ed è molto probabile che i tempi di lavorazione editoriali, sempre ristretti, lo favoriranno – allora i traduttori cominceranno sempre di più a lavorare a partire da una prima sgrossatura fatta da un traduttore automatico, cioè si limiteranno a fare un post-editing. La risposta per fortuna è che gli umani saranno sempre necessari – lo dicono per primi gli stessi progettisti dei motori di traduzione automatica – ma diventeranno dei “tecnici”, anche se molto specializzati, perdendo nella maggior parte dei casi la residua aura di autorialità che hanno oggi.

Potrebbe però anche arrivare una svolta che oggi non siamo in grado di prevedere. Quando la «riproducibilità tecnica» di cui parlava Walter Benjamin ha messo in crisi lo statuto ontologico delle arti figurative, la pittura ha abbandonato il compito di documentazione della realtà e ha intrapreso quello della pura interpretazione, lasciando ai fotografi la riproduzione accurata. Ma a sua volta la fotografia (e poi il cinema) sono diventate delle arti in sé. Chissà che non succeda lo stesso per la traduzione, e che il nuovo “strumento” automatico non favorisca in realtà un nuovo sbocco per la creatività della mente umana.

Al momento, tuttavia, occorre immaginare come evolverà la professione anche nell’immediato, oltre che sul lungo periodo. Perciò, oltre agli esperimenti sui testi pubblicati del paragrafo precedente, ho provato a fare una piccola esperienza empirica di questo nuovo possibile processo di lavorazione su un testo di saggistica inedito in italiano e quindi ancora non disponibile nei corpora di GT. Lavorando in condizioni ottimali (ambiente silenzioso, alta concentrazione), il tempo di elaborazione tra una cartella tradotta tradizionalmente e una tradotta automaticamente e poi post-editata si è rivelato inferiore di circa il 13%. Il confronto non è scientifico, perché andrebbe ripetuto su più testi e su più generi, e condotto con più traduttori per avere dei dati affidabili su un campione rilevante. Ma già così c’è stato un risparmio di tempo che non è trascurabile e che può aumentare sulle lunghe distanze grazie al minore affaticamento mentale e visivo che questo comporta, visto che nel secondo caso da parte del traduttore c’è solo un impegno di post-editing (Post-Editing Effort, PEE) e non di prima traduzione e successiva revisione. Per alcuni tipi di testo, come abbiamo visto, lo scarto può rivelarsi anche più ampio grazie alla maggiore accuratezza del traduttore automatico.

Come ha personalmente sottolineato Paolo Gallina, professore associato di Robotica all’Università di Trieste, è prevedibile che man mano che aumenterà il livello di accuratezza dei traduttori automatici, questi cominceranno ad acquisire uno statuto di autorità linguistica sulla lingua naturale. Gli stessi ingegneri responsabili del nuovo Translate neurale hanno notato (Johnson e altri 2016) che nel processo di traduzione zero-shot sembra prodursi una sorta di meta-lingua o interlingua che racchiude le regole di tutte le lingue che analizza, e che avrà molto probabilmente il destino beffardo di diventare un’autorità esterna al campo in cui opera (essendo una macchina) in virtù della sua rilevanza statistica. Come i risultati della prima pagina di Google sono oggi ritenuti quasi sempre i più corretti, così anche i risultati linguistici di Google Translate saranno accettati come i più rilevanti. Per la traduzione editoriale è chiaramente visibile un rischio di omologazione e riduzione del vocabolario, ma ci sono anche delle opportunità: il traduttore editoriale sarà sempre aggiornato su ciò che è più usato e compreso, e le sue ricerche e i tempi di lavorazione saranno più brevi.

Conclusioni

Stiamo vivendo un periodo forse unico nella storia per livello di complessità e difficoltà di definizione. La bellezza dell’evoluzione tecnologica e della disponibilità della conoscenza quasi alla portata di tutti, senza contare le opportunità di maggiore comprensione tra le persone che si aprono grazie a questi strumenti, generano sentimenti contrastanti di ammirazione e timore. Credo tuttavia che un’accelerazione così spinta in direzione del progresso tecnologico, in tutti i campi, vada accompagnata da una discussione ampia e partecipata sul lavoro umano e sul suo ruolo, che da queste tecnologie verrà presto sostituito. Paul Mason, nel suo recente Postcapitalismo (Mason 2016), ha tracciato un quadro di quello che potrebbe essere un futuro in cui la condivisione delle informazioni cambierà il ruolo del lavoro, che forse non sarà più necessario da parte del singolo ma quasi facoltativo e in gran parte svolto da robot e amministrato dallo stato, con un minor peso di prezzi, valute e finanza nell’economia. È una proposta buona e complessa, a mio parere, ma la soluzione e soprattutto la transizione dovrebbero essere trovate e decise a tavolino, non subite dall’incalzare impetuoso dell’iniziativa del mercato.

Il caso del traduttore, nel suo piccolo, è un ottimo esempio di questa situazione nell’ambito delle scienze umane. Il traduttore è per definizione un lavoratore autonomo, un professionista di alta specializzazione che spende parecchio tempo e denaro nella sua formazione continua. Un’automazione così spinta in così breve tempo darà il colpo di grazia a molti traduttori qualificati in difficoltà, penalizzati già dal calo di lavoro evidenziato soprattutto dalla diminuzione della percentuale di libri tradotti dal quasi 25% del 2009 all’11% del 2016 (Lolli e Peresson 2017). Il pubblico e la committenza non ci metteranno molto ad acquisire la percezione che una macchina può fare comunque decentemente, velocemente e a costo quasi zero un lavoro che prima richiedeva molto tempo e aveva un costo più elevato. Come abbiamo visto, specialmente nella narrativa di genere il tasso di affidabilità dei traduttori automatici è già oggi molto alto, e gli editori prevedibilmente lo sfrutteranno per far tradurre i libri in house, abbassare i compensi, richiedere tempi di lavorazione più stretti e forse anche per cercare di arrogarsi il diritto d’autore sulle traduzioni così prodotte.

Oggi il traduttore cede i diritti di utilizzazione della sua traduzione (in quanto autore) per un certo numero di anni, alla cui scadenza vanno negoziati e pagati nuovamente dalla casa editrice che vuole continuare a pubblicare la traduzione, oppure ceduti a un altro editore. Un domani, gli autori delle traduzioni probabilmente saranno le case editrici stesse, grazie agli editor o alle agenzie che rimaneggeranno il testo sgrossato da un traduttore automatico. Il risultato è che molti traduttori rimarranno senza lavoro, mentre altri gestiranno molte più traduzioni grazie al risparmio di tempo.

Una delle exit strategies più frequentemente proposte nei forum per traduttori è quella di spostarsi verso la fascia di mercato superiore (ad esempio nel post, http://bit.ly/2qGeDza): un’idea che forse è praticabile per molti settori della traduzione tecnica e per clienti come grandi aziende, studi legali internazionali, diplomazia, opere d’arte. E anche in questi campi ci sono difficoltà oggettive che non tutti possono sormontare. Ma la traduzione editoriale, che è notoriamente un mercato “povero”, come può competere con l’apparentemente inevitabile trasformazione del traduttore in post-editor?

A quest’ultima domanda non ho una risposta. Posso immaginare, a partire dai dati degli ultimi anni, da ciò che conosco del mondo dell’editoria e da quanto si ripete costantemente nei processi rivoluzionari, che l’innovazione quanto più è rapida tanto più è iniqua verso chi in tempi normali avrebbe prosperato. Se l’evoluzione sarà veloce come sembra, i traduttori che lavorano per pochi euro a cartella spariranno – e questa potrebbe anche essere una buona notizia: Strade SLC, cioè il Sindacato dei Traduttori Editoriali, e AITI, l’Associazione Italiana Traduttori e Interpreti, hanno sempre insistito molto sulla sensibilizzazione dei soci verso il dumping che purtroppo continua a esistere in questo mercato.

Ma spariranno anche i traduttori che lavorano a compensi oggi ritenuti appena accettabili per sopravvivere, perché diventeranno quelli a cui saranno offerti i compensi da fame dei traduttori estinti di cui sopra. E visto che di solito in questa fascia si collocano dei traduttori consapevoli, molti non li accetteranno e cambieranno mestiere (e infatti molti colleghi lo stanno già facendo). Sopravviveranno bene i traduttori iperformati, quelli che avranno delle competenze talmente ampie e variegate che sarà impossibile fare a meno di loro per molti lavori, che garantiranno sempre il massimo della qualità, che sapranno discutere di tutto con tutti a livelli molto alti e si occuperanno di micro-nicchie. E che, di conseguenza, potranno chiedere le cifre che vogliono. Ma saranno pochi, molto pochi. Molti meno di quanti oggigiorno si laureano e specializzano in Italia tra università e corsi di formazione e aggiornamento, che negli ultimi anni si sono invece moltiplicati.

Non è una visione pessimistica. Non si tratta di altro che dell’applicazione al campo della traduzione del processo di concentrazione delle risorse in pochi soggetti in atto nell’ultimo decennio. È la realtà di oggi che è già pessima e inadeguata alla formazione di un traduttore: anni all’università e una costosa formazione continua raramente riconosciuta da committenti che ricattano con l’inesperienza o col miraggio della visibilità. Google Translate, DeepL e i loro simili libereranno i traduttori dai lavori ingrati che appunto anche una macchina sa fare e lasceranno il settore creativo in mano a chi si saprà costruire un’enciclopedia di conoscenze che permetterà di gestire qualsiasi progetto, una competenza ampia e una professionalità che nessuna macchina potrà scalfire e nessun committente potrà mettere in discussione.

Come diceva qualcuno, la rivoluzione è un atto di violenza. La fase di transizione, che è la vera e propria fase di rivoluzione, lascerà sul campo molte vittime innocenti. Ma innocenti solo fino al punto in cui non saranno loro a lasciarsi sorprendere.

Bibliografia

Adams 1996: Douglas Adams, Guida galattica per gli autostoppisti, Milano, Mondadori (traduzione di Laura Serra da Douglas Adams, The Hitchhiker’s Guide to the Galaxy, London, Pan Books 1979; I edizione italiana: Milano, Mondadori 1980)

Bassnett 2013: Susan Bassnett, Translation Studies. Fourth Edition, London, Routledge (I edizione: 1980)

Bulgheroni 1997: Marisa Bulgheroni (a cura di), Emily Dickinson. Tutte le poesie, trad. di S. Raffo e altri, Meridiani Mondadori, Milano

Economist 2017: Finding a voice, in «The Economist – Technology Quarterly», 7 gennaio 2017 (http://www.economist.com/technology-quarterly/2017-05-01/language: link consultato il 3 gennaio 2018)

Gehring e altri 2017: Jonas Gehring, Michael Auli, David Grangier, Denis Yarats, Yann N. Dauphin, A novel approach to neural machine translation, 9 maggio 2017 (https://code.facebook.com/posts/1978007565818999/a-novel-approach-to-neural-machine-translation/; link consultato il 3 gennaio 2018)

Grillo 2016: Marzia Grillo (a cura di), Charter in Delirio! Un esperimento con i versi di Emily Dickinson, Testi scelti con traduzione automatica a fronte, postfazione di Martina Testa, Roma, Elliot

Guardian 2017: Tomic v Evans, live, in «The Guardian», 20 gennaio 2017, https://www.theguardian.com/sport/live/2017/jan/20/bernard-tomic-v-dan-evans-australian-open-round-three-live (link consultato l’8 gennaio 2018)

Johnson e altri 2016: Melvin Johnson, Mike Schuster, Quoc V. Le e altri, Google’s Multilingual Neural Machine Translation System: Enabling Zero-Shot Translation, ArXiv.org, https://arxiv.org/abs/1611.04558 (link consultato il 3 gennaio 2018)

Kuhn 2009: Thomas Kuhn, La struttura delle rivoluzioni scientifiche, Torino, Einaudi (traduzione di Adriano Carugo da The Structure of Scientific Revolutions, Chicago, University of Chicago Press 1962; I edizione italiana Torino, Einaudi 1969)

Lewis-Kraus 2016: Gideon Lewis-Kraus, The Great A.I. Awakening, in «The New York Times Magazine», 14 dicembre 2016 (https://www.nytimes.com/2016/12/14/magazine/the-great-ai-awakening.html?_r=0; link consultato il 3 gennaio 2018)

Lolli, Peresson 2017: Rapporto sullo stato dell’editoria in Italia 2017, a cura di Antonio Lolli e Giovanni Peresson, Milano, Ediser

Mason 2016: Paul Mason, Postcapitalismo. Una guida al nostro futuro, Milano, Il Saggiatore (traduzione di Fabio Galimberti da Paul Mason, Postcapitalism. A Guide to our Future, Jouve, Allen Lane 2015)

Och 2006: Franz Och, Statistical Machine Translation Live, post del 28 aprile 2006 sul blog di ricerca Google (https://research.googleblog.com/2006/04/statistical-machine-translation-live.html; link consultato il 3 gennaio 2018)

Papineni e altri 2002: Kishore Papineni, Salim Roukos, Todd Ward e Wei-Jing Zhu, BLEU: a Method for Automatic Evaluation of Machine Translation, in Proceedings of the 40th Annual Meeting of the Association of Computational Linguistics (ACL), Philadelphia, July 2002, pp. 311-318 (http://aclweb.org/anthology/P/P02/P02-1040.pdf; link consultato il 3 gennaio 2018)

Petrelli 2013: Nicholas Sparks, Le parole che non ti ho detto, Milano, Sperling&Kupfer (traduzione di Alessandra Petrelli da Sparks 1998; I edizione: Milano, Frassinelli 1998)

Schuster e altri 2016: Mike Schuster (Google Brain Team), Melvin Johnson (Google Translate) e Nikhil Thorat (Google Brain Team, https://research.googleblog.com/2016/11/zero-shot-translation-with-googles.html; consultato il 3 gennaio 2018)

Sparks 1998: Nicholas Sparks, Message in a Bottle, London, Sphere, 2011, reperibile al https://books.google.it/books?id=TG2tD0BLGfwC&pg=PT12&hl=it&source=gbs_toc_r&cad=4#v=onepage&q&f=false (I edizione: New York, Warner Books, 1998)

Toral 2018: Antonio Toral, blog «eMpTy Pages» (http://kv-emptypages.blogspot.it/; link consultato il 3 gennaio 2018)

– 2016: Vecchia pagina personale di Antonio Toral in Dublin City University, http://www.computing.dcu.ie/%7Eatoral/ (link consultato il 3 gennaio 2018)

Venuti 1999: Lawrence Venuti, L’invisibilità del traduttore. Una storia della traduzione, Roma, Armando editore (traduzione di Marina Guglielmi da Lawrence Venuti, The Translator’s Invisibility. A History of Translation, London, Routledge 1995)

Wu e altri 2016: Yonghui Wu, Mike Schuster, Zhifeng Chen e altri, Google’s Neural Machine Translation System: Bridging the Gap between Human and Machine Translation, ArXiv.org, 8 ottobre 2016 (https://arxiv.org/abs/1609.08144; link consultato il 3 gennaio 2018)